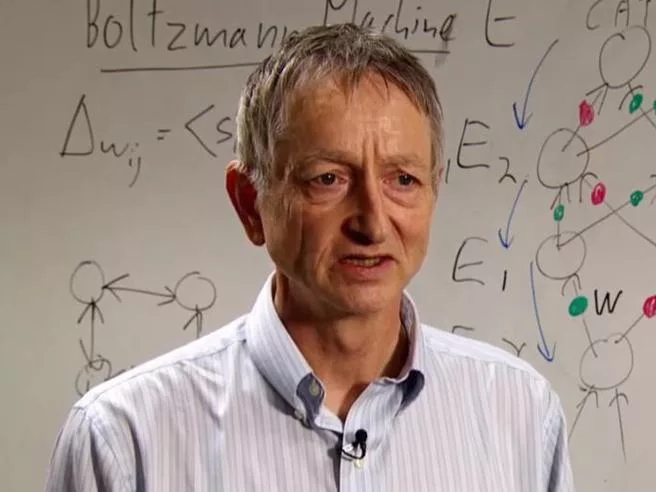

I due rischi più spaventosi dell’Intelligenza artificiale secondo Geoffrey Hinton, il suo «padrino»

Lo scienziato inglese, 75 anni, ha lasciato il suo posto a Google per poter spiegare nel dettaglio i pericoli a cui il mondo va incontro: «Quasi impossibile individuare e neutralizzare gli “attori maligni” che la useranno. E potrebbe prendere decisioni non previste»

«Se siete diventati dipendenti dai like è colpa mia: sappiate che ho contribuito a crearli». «Se mentre navigate in rete e parlate di un oggetto venite bombardati dalla pubblicità su quella cosa, prendetevela con me: vorrei non aver sviluppato quelle tecniche di microtargeting».

Nell’era delle reti sociali, ingegneri e computer scientist padri di tecnologie usate in modo spregiudicato dai giganti di big tech si sono pentiti in massa di quanto avevano fatto, ma solo a buoi ormai usciti dalla stalla: insieme a tanti contributi positivi, danni sociali e anche politici ormai irreversibili.

La lezione è servita: nell’era dell’intelligenza artificiale che comporta rischi di abusi e di perdita del controllo della tecnologia assai maggiori, allarmi e pentimenti stanno arrivando a raffica, prima che i danni si materializzino.

A unirsi a quel coro, ora è un personaggio che, impegnato da oltre dieci anni nella frontiera più avanzata dell’intelligenza artificiale (è il creatore delle cosiddette «reti neurali»), oggi non si limita a denunciare gli enormi rischi connessi allo sviluppo di macchine in grado di ragionare e prendere decisioni in modo autonomo: Geoffrey Hinton si è addirittura dimesso dal suo incarico scientifico in Google per poter essere più libero di spiegare in dettaglio all’opinione pubblica i pericoli ai quali va incontro.

Il 75enne scienziato inglese non parla, come fanno altri, di macchine che potrebbero diventare coscienti. Si concentra, piuttosto, su due categorie di rischi.

Il primo, peraltro già denunciato anche da Jen Easterly, massima autorità del governo Usa nel campo della cybersecurity, riguarda l’estrema difficoltà di individuare e neutralizzare i molti «attori maligni» che si apprestano a usare le enormi capacità dell’intelligenza artificiale per diffondere immagini, video, documenti e codici informatici falsi: la verità, sempre più incerta, che rischia di diventare irrilevante. E il rischio di attacchi sempre più sofisticati di hacker in grado di paralizzare interi sistemi informatici, mettendo in ginocchio aziende o, anche, infrastrutture essenziali (elettricità, acqua, reti informatiche) di interi Paesi.

La seconda categoria di rischi è quella della macchina che sfugge al controllo dell’uomo: Hinton non disegna scenari fantascientifici di ribellioni di computer che acquistano coscienza di sé, ma nota che intelligenze artificiali alle quali viene consentito non solo di generare i loro codici informatici, ma anche di gestirli in modo totalmente autonomo, arrivano a formulare ragionamenti e a prendere decisioni che non possono essere previste dai creatori dei programmi.

Un’ulteriore difficoltà nasce dalla differenza tra l’intelligenza umana che è biologica, e quindi unica, e quella artificiale che è basata su sistemi digitali replicabili all’infinito. La superintelligenza può nascere semplicemente dalla moltiplicazione delle copie di una AI: ognuna di esse impara separatamente, ma condivide la conoscenza acquisita con le altre macchine «gemelle».

Quando sono scesi in campo oltre mille accademici e imprenditori guidati da Elon Musk per lanciare l’allarme dopo la diffusione planetaria di ChatGpt , e chiedere una moratoria di 6 mesi di ogni ricerca in questo campo, molti hanno sospettato una ripicca del padrone di Twitter, Tesla e SpaceX. O un tentativo di rallentare lo sviluppo tecnologico per dar tempo a X.AI, la sua neonata società di intelligenza artificiale, di recuperare terreno. Ma anche Sam Altman, capo di OpenAI e «padre» di ChatGpt ammette che la nuova tecnologia comporta grandi rischi, oltre a immense opportunità, e va gestita con cautela, mentre qualche settimana fa, dopo la presentazione di un sistema ancor più avanzato, GPT 4, un’altra lettera della Associazione per il Progresso dell’AI che invita a un’estrema prudenza, è stata firmata anche da Eric Horvitz, capo degli scienziati di Microsoft: il gruppo che sta introducendo la nuova tecnologia di intelligenza artificiale in tutti i suoi prodotti.

Hinton non ha firmato le due lettere: non perché non ne condivida il contenuto, ma perché ritiene impossibile una moratoria sulla ricerca, a meno che non si arrivi a un impegno corale di tutti gli scienziati del mondo: mentre nel caso del nucleare è possibile controllare lo sviluppo fisico degli elementi necessari per costruire un’arma, verificare l’avanzamento della ricerca informatica di un laboratorio è pressoché impossibile.